Технологія діпфейків стає все поширенішою, особливо в сферах порнографії та політиці. І якщо у першому випадку шкоди завдають особистим правам особи, чиє зображення використали без її згоди, то у другому ця технологія може підірвати довіру суспільства до державних інституцій та ЗМІ

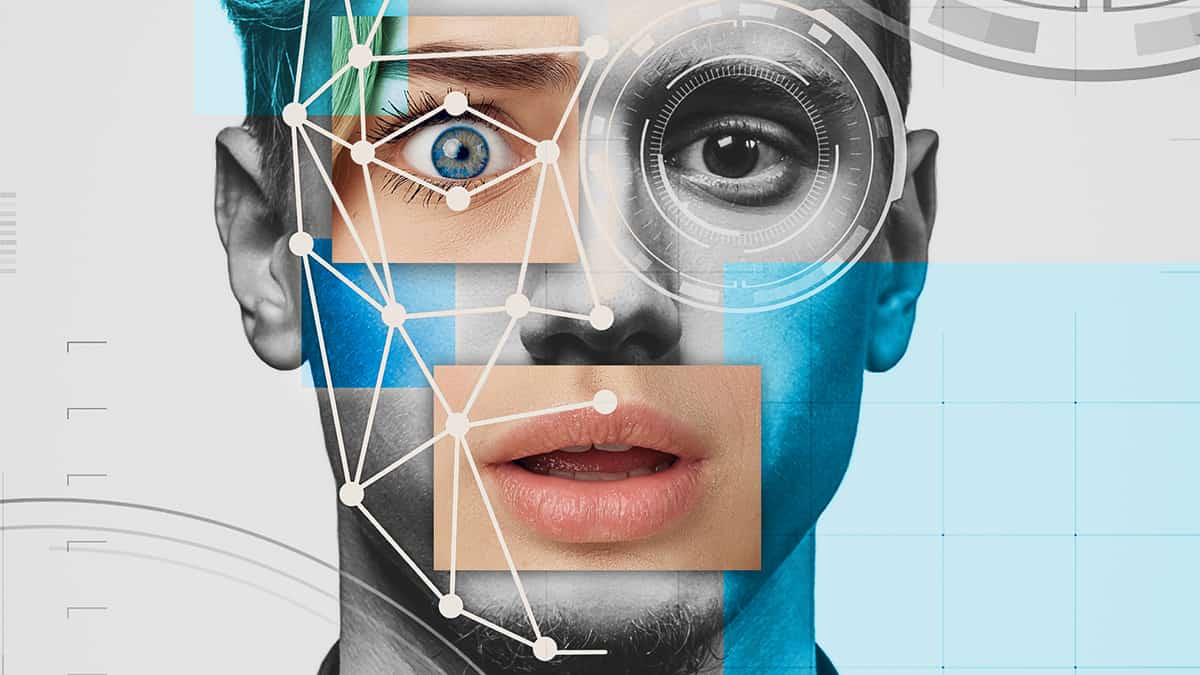

Поняття діпфейку (deepfake) походить з англійської мови. Воно утворилося через поєднання термінів deep learning («глибинне навчання») та fake («підробка»). Для створення діпфейку потрібно за допомогою штучного інтелекту поєднати або накласти зображення людини на інші картинки або відеоролики. На перший погляд, це складно, але технологія настільки добре розвинена, що такий продукт за допомогою спеціальних програм може створити хто завгодно. Такі програми не лише створюють візуальну частину ролика, а й синхронізують голос, рухи та жести. В результаті отримуємо відео, де доволі точно зображена потрібна нам людина.

Нерідко цю технологію використовують у кіно, щоб, наприклад, оживити давно померлих акторів. Наприклад, у 2016 році так зробила компанія “Дісней”, ожививши у продовженні “Зоряних війн” Пітера Кушенга та Керрі Фішера (акторів, які грали у перших частинах саги).

Водночас згідно з дослідженням, яке у 2019 році провела компанія Deeptrace, найчастіше цю технологію використовують у порнографії та політиці.

Діпфейки та дорослий контент

Діпфейки використовують для того, щоб створити порнографічний контент зі знаменитостями або людьми, які не давали на це згоди. Найчастіше жертвами такого використання стають жінки. Згідно зі вже згаданим дослідженням, 96% діпфейк-контенту в інтернеті — це порнографія, і на 99% таких підроблених відео зображені обличчя відомих жінок на тілах порноакторок.

Існує безліч додатків, які допомагають зробити подібний порнографічний контент. Наприклад, вебсайт Deepsukebe обіцяє "оголити все" одним натисканням кнопки. У березні 2023 року у фейсбуці та інстаграмі поширювали відео зі британською акторкою Еммою Вотсон, яка імітує статевий акт. Як повідомляє NBC, ця реклама стала частиною масштабної кампанії додатка для створення діпфейків, який дозволяє користувачам замінити будь-яке обличчя на будь-якому відео.

Однак навіть якщо держави будуть блокувати подібні сайти чи додатки, код, що лежить в основі інструментів "зняття одягу" з фотографій жінок, існує у відкритих репозиторіях. Як зазначає журналістка The Guardian Мойра Донеген, “Те, що ці додатки пропонують своїм користувачам, — це конкретна і явна можливість завдати шкоди жінкам, примушуючи їх до порнографії проти їхньої волі”.

Все більше жінок скаржаться, що їхні обличчя використовують у порновідео проти їхньої волі. Популярна в Америці стрімерка помітила відео зі своїм обличчям на американському сайті з діпфейк-порнографією, а британська поетеса побачила, що фотографії голих жінок із її обличчям розмістили на якомусь порнографічному вебресурсі. Жінку також здивувало, що фотографії були взяті з її приватного акаунта з фейсбуці, який вона видалила за кілька років до інциденту.

Створення подібних діпфейків — не лише моральна проблема. Така діяльність безпосередньо шкодить жінкам, зображення яких використовують проти їхньої волі. Їх можуть переслідувати, знаходити в інтернеті, “сталкерити” та “закидати” непристойними пропозиціями, а їхні родичі й рідні можуть не мати достатнього рівня медіаграмотності, щоб зрозуміти, що відео чи картинка несправжні. Як зазначають дослідники, за наслідками травматизації подібний контент прирівнюється до “порнопомсти” (оприлюднення оголених фото особи без її або його згоди).

Діпфейки у політиці

Діпфейки часто використовують як політичний інструмент для того, щоб маніпулювати суспільною думкою та підривати довіру до державних інституцій, політиків і ЗМІ, особливо перед виборами.

Так, наприклад, у Південній Кореї колишній прокурор ледь не виграв президентські вибори, коли його прихильники, аби залучити молодих виборців, створили діпфейк-копію політика, яка відповідала на політичні питання. Хоча творці не приховували, що відео є підробкою, із коментарів у соціальних мережах не зрозуміло, чи всі виборці це усвідомлювали.

В Україні зловмисники використовували діпфейки, щоб маніпулювати думкою західних партнерів та українського суспільства.

Зокрема, влітку мерам Берліна, Відня, Мадрида, Будапешта і Варшави подзвонив підроблений мер Києва Віталій Кличко. Очільниця міста Берлін Франциска Ґіффай розмовляла з підробленим Кличком за допомогою відеозв’язку, і протягом розмови у неї поступово зароджувалися сумніви у справжності співрозмовника. Останньою краплею стало те, що псевдо-Кличко попросив допомогти організувати День вулиці Христофора, що дивно, враховуючи війну в Україні. Також удаваний Кличко був у зимовому одязі, хоча розмова відбувалася влітку, коли у Києві доволі спекотно. Ба більше, він розмовляв з колегою російською мовою, хоча їй відомо, що Віталій Кличко знає німецьку, адже він довгий час жив у Гамбурзі. Після 30 хвилин розмови очільниця Берліна перервала дзвінок.

фото зі дзвінка оприлюднила канцелярія мера Берліна

Як розповідає німецький таблоїд Bild, мер Відня Міхаель Людвіг нічого не помітив і навіть розіслав після розмови пресреліз та опублікував повідомлення у Твіттері німецькою й англійською, в якому детально відзвітував про розмову. Він написав, що Кличко має "надійного партнера у Відні для підтримки українців".

Міські голови європейських столиць вважають, що через подібні дзвінки зловмисники хотіли дискредитувати Україну перед міжнародними партнерами. На щастя, обман викрили доволі швидко.

Ще одним відомим випадком використання діпфейків в Україні було повідомлення Володимира Зеленського про капітуляцію на початку березня 2022 року. Тоді зловмисники зламали рухомий рядок телемарафону та показали там неправдиву інформацію. Втім, відеоовідомлення було настільки поганої якості, що в його справжність майже ніхто не повірив.

Однак, як зазначають експерти, хакери мали на меті перш за все не обдурити населення, а підірвати його довіру до українських ЗМІ та державних інституцій. Зловмисники хотіли показати, що уряд та медіа не є надійними джерелами інформації й не можуть захистити свої системи від хакерського проникнення.

Правове регулювання

З правового погляду такі оманливі відео порушують право особи на честь і гідність та приватність, завдають шкоди її діловій репутації тощо. Подібні дії можна оскаржити в суді. Згідно з українським (ЗУ “Про захист персональних даних”) та європейським (GDP.R) законодавством, приватні дані людини, за якими її можна ідентифікувати — передовсім фотографії — можна використовувати або обробляти лише за умов, чітко визначених у нормативних актах. Саме тому, якщо чиїсь фотографії використовують у подібних відео без його чи її згоди, таке використання порушує права людини.

Втім, тут є важливе “але”: якщо діпфейк створений як політичний коментар або сатира над політиком, таке відео має право на існування і захищається правом на свободу слова.

Небезпека діпфейків і боротьба з ними

Основна небезпека діпфейків полягає в тому, що люди не вміють розрізняти підроблене зображення від справжнього. Відповідно, наразі існує кілька основних способів боротьби зі зловживанням цією технологією: юридичний, технологічний і освітній.

Юридичний передбачає заборону або обмеження використання діпфейків у публічному просторі. Наприклад, у законодавстві багатьох країн про захист персональних даних існує заборона на використання облич людей без їхньої згоди. Натомість у політичній сфері способи захисту від діпфейків лише розвивають. Так, у деяких країнах розробляють політики регулювання цифрової реклами, щоб унормувати конкуренцію між політичними партіями та означити дозволені механізми. В Україні таке законодавче регулювання поки не розвинене, але у США деякі штати активно стали на стежку боротьби з діпфейками. Зокрема, в Техасі ухвалили закон, який прямо забороняє розміщення або публікування діпфейків з метою негативного впливу на кандидата або виборчий процес.

З діпфейками можна боротися їхніми ж інструментами — створювати програми, які можуть підтвердити справжність відео. Для цього використовують алгоритми, схожі на алгоритми побудови діпфейків. Однак як тільки компанії, що борються з діпфейками, знаходять швидкий спосіб упізнавання оманливих відео, конкуренти реагують на це й усувають недолік у програмі діпфейку. Так, наприклад, було з кліпанням очей: щойно борці з діпфейками виявили, що на оманливих відео люди не блимають, творці фальшивок швидко зробили так, що персонажі на відео почали це робити. Саме тому технічний спосіб боротьби з діпфейками часто заганяє людей, які прагнуть розкривати маніпулятивні відео, і творців цих відео у коло, де одні постійно шукають недоліки, а інші їх виправляють, щоб бути менш помітними.

Ще одна проблема технічного підходу — в тому, що для його розвитку потрібні інвестиції, а далеко не всі уряди прагнуть чи можуть вкладати кошти в цю сферу. Скажімо, в Німеччині медійні компанії розпочали спільний дослідницький проєкт ”Digger” для боротьби з діпфейками, однак уряд Німеччини поки що не має наміру його фінансувати.

Деякі соціальні мережі, зокрема ті, що належать “Мета”, а також твіттер, із власної ініціативи запроваджують інструменти саморегуляції. Наприклад, у 2020 році вище керівництво “Фейсбука” повідомило, що видалятиме діпфейки, які не відповідають правилам спільноти.

Врешті, ще один спосіб зменшення впливу діпфейків на суспільство — розвиток медіаграмотності населення. Потрібно навчати людей розрізняти діпфейки від справжніх новин, звернень політиків та інших способів донесення інформації, які можна підробити. Таке навчання потрібно проводити для людей різного віку — від дітей у школах та дитячих садочках до пенсіонерів, які найлегше піддаються маніпуляціям.

На жаль, поки що не існує одного абсолютно досконалого й ефективного методу боротьби з діпфейками. Аби зменшити шкоду від цієї технології, всі названі вище способи слід використовувати паралельно. Зрозуміло, що повністю заборонити діпфейки ми не можемо, адже на цю технологію існує суспільний попит, найперше в кіно та інших розважально-культурних сферах.