Протягом останніх кількох років ми спостерігаємо справжній вибух технологій штучного інтелекту: він припускає, що ми хочемо знайти, коли починаємо вводити запит у гуглі, організовує нашу поштову скриньку, фільтруючи листи та переспрямовуючи їх у відповідні розділи, або ж пропонує нам музику у Spotify чи відео на ютубі. Нещодавно запущений в Україні Chat GPT, який може створити меню на тиждень або написати код у Python — також приклад штучного інтелекту.

І хоча ШІ може бути незамінним помічником у нашій повсякденній роботі? спрощуючи пошук та аналіз потрібної інформації, він також поступово стає корисним інструментом для створення та поширення дезінформації. До прикладу, як раніше вже пояснювала ОПОРА, Chat GPT може стати корисним джерелом для російської пропаганди. А у лютому 2023 року використання штучного інтелекту для створення пропаганди та діпфейків (фейкових відео) зафіксували одразу в двох країнах: Китаї та Венесуелі. ОПОРА розібралась, як ці країни використали переваги штучного інтелекту для просування потрібних повідомлень і чому технології ШІ поступово стають все більшою загрозою для світової інформаційної безпеки.

Венесуела

З 1999 року дотепер у Венесуелі було лише два президенти: Уго Чавес (1999–2013) та Ніколас Мадуро (2013–2019), обидва — з соціалістичної партії. За рік після приходу до влади Мадуро через бідність, економічні негаразди та поширеність насильства на вулицях у країні розпочалися протести, що тривали до 2019 року. Тоді у Венесуелі відбулися вибори, на яких переміг Мадуро. Однак у внутрішніх і зовнішніх спостерігачів виникли сумніви у чесності їх проведених. Зрештою, Мадуро відсторонили від посади президента, і з того часу його обовʼязки виконує голова Національних зборів Хуан Гуайдо. Мадуро натомість вважає призначення Гуайдо нелегітимним і намагається відновити владу.

Мадуро почав використовувати соціальні мережі для просування своїх політичних поглядів та потрібних йому ідей доволі давно. Місцева громадська організація ProBox ще у 2018 році зафіксувала використання ботів та проплачених твіттер-акаунтів для популяризації певних хештегів і спрямування онлайн-розмов у потрібне для влади русло. Наприклад, вранці кожного дня твіттер-акаунт Міністерства зв’язку та інформації Венесуели публікував хештег #LasSancionesSonContraElPueblo (СанкціїПротиЛюдей), якій згодом поширювався через мережі акаунтів всередині Венесуели і поза нею. Він спрямований на те, щоб звинуватити в економічних проблемах Венесуели США, які ввели санкції проти цієї держави через корупцію вищого керівництва. Понад те, ProBox виявила, що акаунти справжніх користувачів, які погоджуються просувати ці хештеги, отримують грошовий бонус (від 3 до 5 доларів за один допис) через Sistema Patria — державну цифрову платформу, через яку венесуельці отримують пенсії та інші державні виплати.

Після відсторонення від влади Мадуро не перестав інвестувати у соціальні мережі. Підтримуючи свою армію ботів, він почав використовувати у своїй політичній діяльності сучасніші технології, зокрема й штучний інтелект. У лютому 2023 року видання El Pais зафіксувало в англомовному інтернет-просторі фейкові відео, створені та поширені chavismo — так у Венесуелі називають прихильників Мадуро. В одному з таких відео у форматі короткого новинного випуску англомовний ведучий доводив глядачам, що економіка Венесуели “насправді не знищена”. Як аргумент він розповідав про заповненість дорогих венесуельських готелів під час карнавалу — мовляв, венесуельці витрачають купу грошей на карибські пляжі, а тому не варто думати, що вони аж такі бідні. В іншому відео ведучий обговорював прибутки країни від професійного бейсбольного турніру Caribbean Series у Каракасі: венесуельці витратили під час змагань понад 10 мільйонів доларів на квитки та 7 мільйонів доларів на їжу. Джерела цих даних, звісно, не повідомляють.

Поширені фейкові відео мали сотні тисяч переглядів на ютубі, стали вірусними у соціальних мережах, зокрема в TikTok, і згодом циркулювали як платна реклама на цих платформах. Понад те, ці відео транслювали на державному мовнику Venezolana de Televisión — одному з найпопулярніших телеканалів, тісно афілійованому з Ніколасом Мадуро.

Китай

На початку лютого 2023 The New York Times повідомили, що дослідницька організація Graphika, яка вивчає дезінформацію, виявила в інтернет-просторі США китайські фейкові відео. За словами Graphika, китайська кампанія впливу просувала інтереси Комуністичної партії Китаю та підривала репутацію Сполучених Штатів, орієнтуючись на англомовних глядачів.

В одному з відео “ведучий” наголошував, що Сполучені Штати діють ганебно, оскільки не перешкоджають війнам та підтримують насильство, надсилаючи зброю іншим країнам. В іншому відео “ведуча” розповідала про роль Китаю у геополітичних відносинах та показувала кадри з різних міжнародних самітів.

Graphika повідомила, що виявила підроблені відео під час дослідження акаунтів у соціальних мережах, повʼязаних із прокитайською кампанією дезінформації, відомою як “спамуфляж”. У цих кампаніях одні акаунти розміщують потрібний китайській владі контент, а потім інші акаунти поширюють ці матеріали на різних платформах. За словами дослідників, два відео з “ведучими новин” поширювали у соціальних мережах щонайменше п’ять разів у період з 22 по 30 листопада. Просували ці відео сім облікових записів, які, схоже, є частиною великої прокитайської мережі. В основному мережа використовувала платформи компанії “Meta” — фейсбук та Інстаграм, а також твіттер. За словами The New York Times, “Meta” повідомила, що видалила принаймні один обліковий запис, пов’язаний із прокитайською дезінформацією, а от у “Твіттері” від коментарів відмовилися.

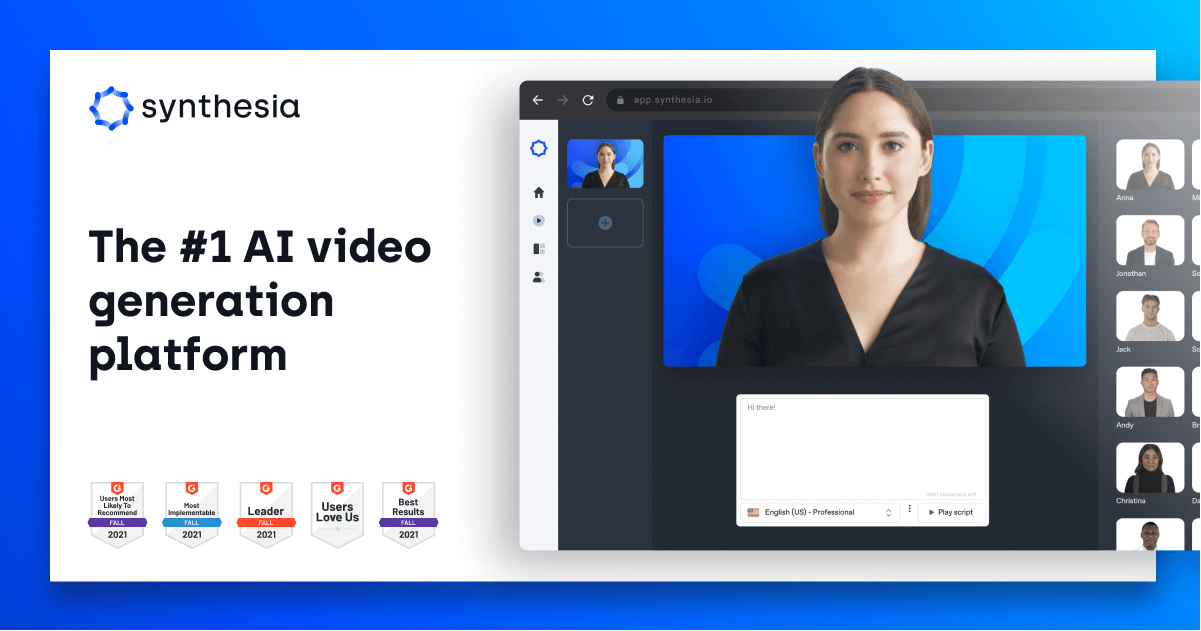

Synthesia або як це стало можливим

В обох випадках — як у Венесуелі, так і в Китаї, — основою кампаній впливу стала британська компанія штучного інтелекту Synthesia. Її створили у 2017 році підприємці та дослідники зі США та країн Європи, аби “дати можливість кожному створювати відео без камери, мікрофону та студії”.

Зареєструвавшись на сайті та заплативши лише 30 доларів на місяць, ви можете обрати собі “аватара” або “цифрового близнюка”, як називає його сама компанія. “Цифрові близнюки” — це найняті актори, які продали свої зображення компанії. Всього Synthesia пропонує майже 90 “аватарів” різної статі, віку, етнічного походження, із різним тембром голосу та стилем одягу. “Аватари” можуть говорити 120 різними мовами (в тому числі й українською) та навіть імітувати потрібні клієнту акценти. Клієнти Synthesia також можуть створювати “аватари” власноруч — на основі себе чи інших людей, які надали їм дозвіл. Після цього ви створюєте письмовий сценарій та детально описуєте, що та як має говорити “цифровий близнюк”. Натиснувши кнопку “згенерувати відео”, за декілька хвилин вам на електронну пошту надходить лінк на готовий ролик. До речі, подібне відео можна згенерувати навіть безкоштовно — наприклад, ось таке зробили ми:

Як пише The New York Times, у відповідь на закиди медіа щодо використання технології для створення дезінформації, засновник та виконавчий директор Synthesia Віктор Ріпарбеллі заявив, що користувачі, які створили ці відео, порушили правила компанії. Справді, на сайті компанії можна знайти етичний кодекс, відповідно до якого відео, створені на платформі, не мають містити “політичного, сексуального, особистого або дискримінаційного контенту”, а також поширювати дезінформаційні повідомлення. Для запобігання таким випадкам компанія впровадила попередню модерацію: тексти, які має говорити ваш “аватар”, проходять перевірку. Її проводить команда з 4 людей. Втім, як ми бачили вище, і в Китаї, і у Венесуелі внутрішня модерація Synthesia не стала перепоною для створення відверто дезінформаційних відео. За словами Ріпарбеллі, після перегляду одного з відео китайських пропагандистів, створених за допомогою Synthesia, “дуже важко переконатися, що це справді дезінформація”.

Чи справді це така велика загроза?

У більшості випадків фейкові відео сьогодні залишаються доволі неякісним продуктом — часто те, що говорять “ведучі” на екрані, не збігається із їхньою мімікою та жестами, а час від часу штучний інтелект помиляється й у наголосах на незнайомих словах. Однак найбільша проблема полягає у тому, що штучний інтелект навчається. Нині, коли цей інструмент стає доступним для все більшої кількості користувачів, а інтерес до нього зростає, спонукає інвестиції у розвиток штучного інтелекту. Так, якщо порівняти, наприклад, минулорічне відео з так званою “капітуляцією” Володимира Зеленського та України перед росією, із китайськими й венесуельськими новинними відео, які генерував штучний інтелект, помітний суттєвий прогрес у цих технологіях.

Швидше за все, штучний інтелект і далі навчатиметься створювати все більш реалістичні відео. Тоді державам, які прагнуть поширити корисні для себе наративи, стане набагато легше їх просувати.