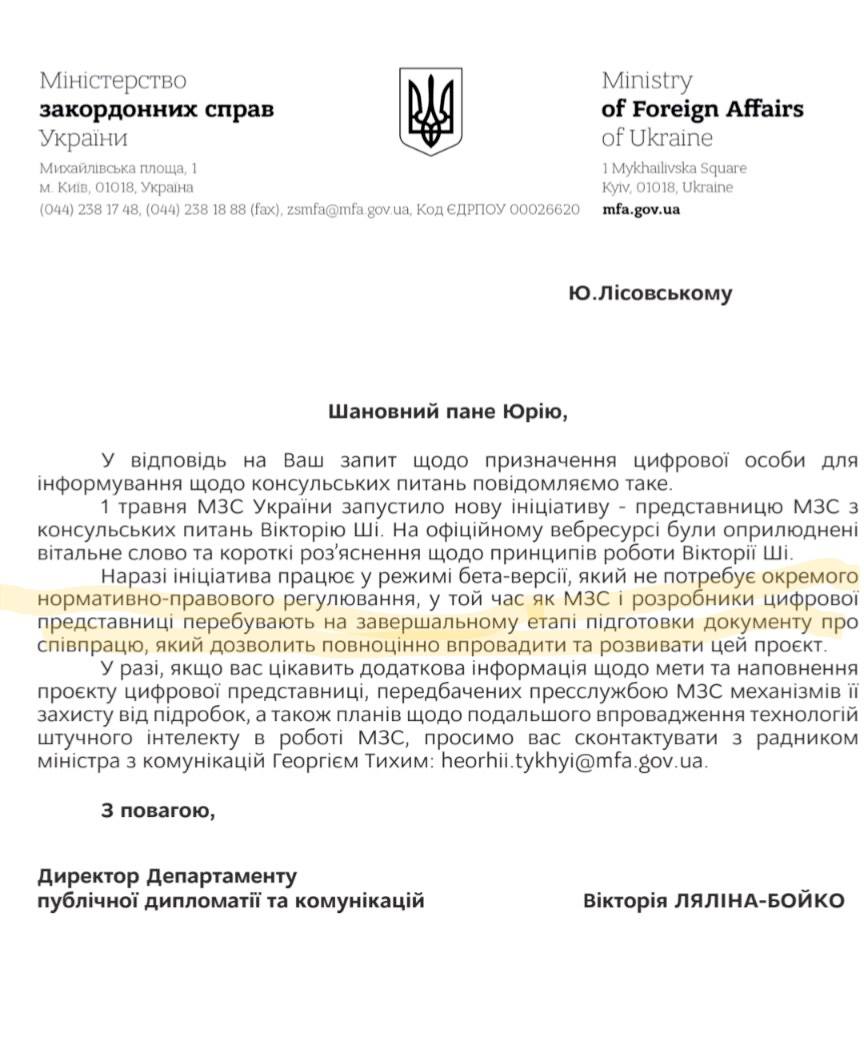

Через те, що користуватись ШІ зараз круто, є вже кілька органів влади, які публічно казали про те, що застосовують його у своїй роботі: НАЗК та Верховна Рада. Проте кожного разу, при вивченні питання детальніше у відповідь на інфозапит, вони насправді повідомляли, що лише ознайомлювались із роботою чи просто використовували модний термін. Цього разу ШІ вирішили застосувати й у МЗС, щоб допомагати отримувати консульські послуги за кордоном. Підхід цікавий, адже замість цілого кол-центру і багатьох людей в різних країнах може працювати компʼютер. Проте, на запит прийшла відповідь, що опублікований чат-бот "Вікторія ШІ" це лише ініціатива (тут питання до юристів, чим у нас регламентуються ініціативи?) МЗС і вони вже готують документи про співпрацю з розробниками бота.

Що тут не так? Щонайменше дві речі:

1) Консульські питання — це часто про персональні дані, а значить чутлива тема. Ми ж і до прийняття GDPR (Загальний регламент про захист даних у межах Європейського Союзу) ідем в ЄС. Якщо немає жодних офіційних документів про роботу чат-бота, що відбувається з персональними даними, які люди могли б туди передати?

2) Як можна в публічний державний реліз пускати щось саморобне? Як цей інструмент пройшов КСЗІ (Комплексна система захисту інформації)?

Використовувати "штучний інтелект" в роботі — все ще модно і виглядає дуже розумно. Він вміє багато, може працювати швидко і майже не відрізняється від людини. Допоки ви маєте з цим справу на побутовому рівні, все так і залишиться. Проте ШІ у роботі державних органів має шалену кількість обмежень і ризиків. А все тому, що він не ідеальний, а за помилки треба нести персональну відповідальність. До прикладу, якщо людина в якомусь міністерстві просить ChatGPT узагальнити документ з обмеженим доступом і переписати його краще, то це все одно, як опублікувати його в Інтернеті, а якщо там є персональні дані, то це означає ще й розголосити їх комусь сторонньому. Можна припустити, що дуже мало людей будуть у захваті від того, щоб їхні дані розголошувались і деякі можуть навіть звернутись до Омбудсмена, щоб зафіксувати порушення. І звичайно ж, мало який держслужбовець буде публікувати дані, але чи всі розуміють, що "надіслати документ в ChatGPT = передати стороннім"?

Наостанок давайте згадаємо про безпеку та точність таких сервісів. Консульські послуги пов’язані із чутливими для кожної людини питаннями. При цьому, різні моделі ШІ (LLM —Велика мовна модель, але давайте спростимо) можуть мати проблеми із розумінням трактування складних і заплутаних питань. Лише маючи себе за приклад я можу припустити, що багато із моїх питань колеги та друзі не розуміють з першого разу, а вони знають мене багато років і часто розуміють контекст. Від чат-боту ми очікуємо рішення, а не менторства у розв’язанні проблем. Якщо це ускладниться до того, що у відповідь людина отримає некоректну відповідь і витратить час, то краще не стане нікому. Додатково, якщо ШІ буде вчитись на цих питаннях, то відбудеться щось на зразок "самовтілюваного пророцтва".

Окремий виклик — недосконалість ШІ. Будь ласка, пригадайте як після виходу ChatGPT всі почали "звільняти" СММ-ників, копірайтерів та перекладачів бо ті не ефективні, але щось таки не сильно назвільняли поки. Тим часом, в деяких університетах з’явились курси з використання ШІ. Для мене в цьому проглядається виклик: ми хочемо спростити чутливу сферу запровадженням інструменту, але в той же час вчимо ним користуватись дорослих людей в університетах. Проміжок для помилок виглядає дуже великим.

Бажання використовувати технології завжди похвальне, та варто визначати методи впливу та їхні конкретні наслідки. А для цього треба, як пропонує Маніфест критичного інжинірингу, зважати на техно-політичну грамотність всього суспільства та дивитись за рамки "благоговіння перед впровадженням".

Оригінальна публікація: ЦЕНЗОР.НЕТ